[딥러닝을이용한 자연어 처리 입문] 1401 바이트 페어 인코딩(Byte Pair Encoding, BPE)

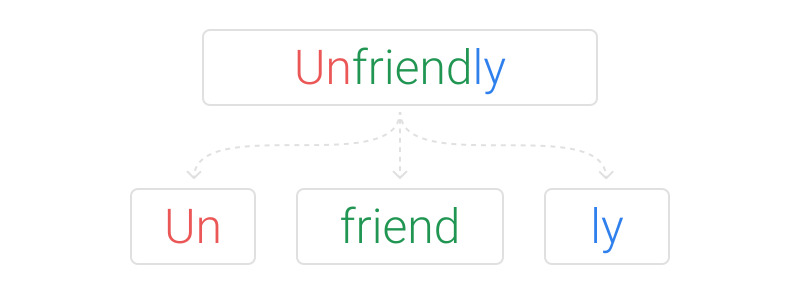

- Subword Tokens & Segmentation

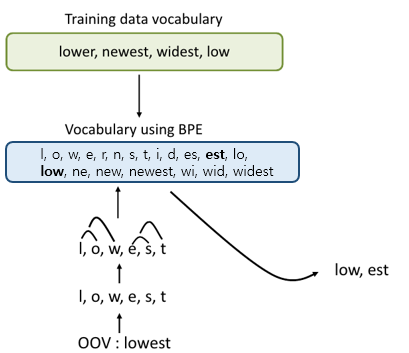

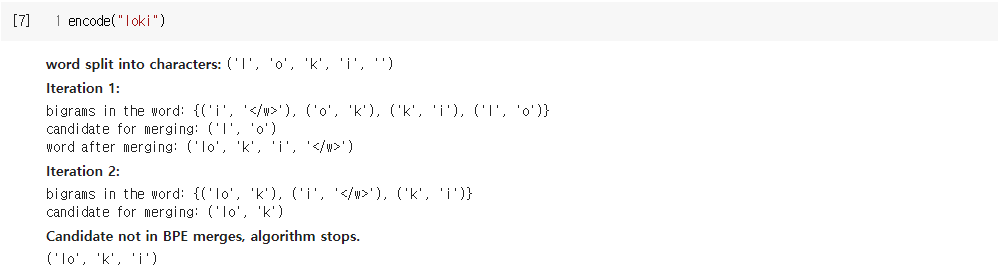

- OOV, 희귀 단어, 신조어와 같은 문제를 완화시킬 수 있음

- BPE(Byte Pair Encoding)

- Wordpiece Model

- Unigram Language Model Tokenizer

1. BPE(Byte Pair Encoding)

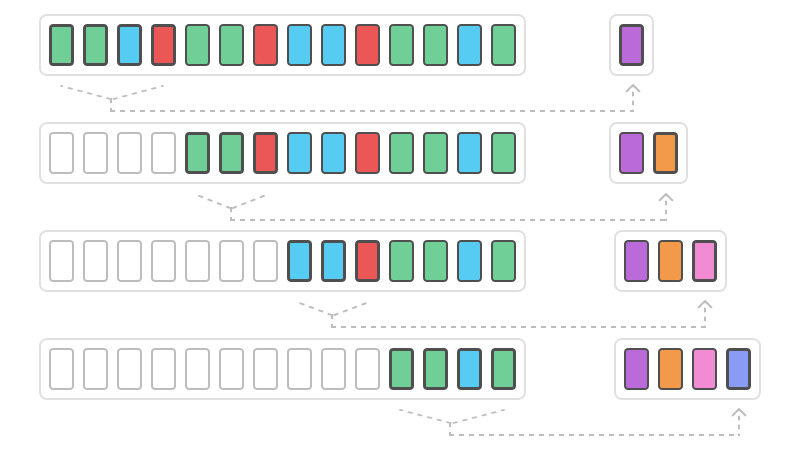

- BPE의 글자 압축(병합) 방식

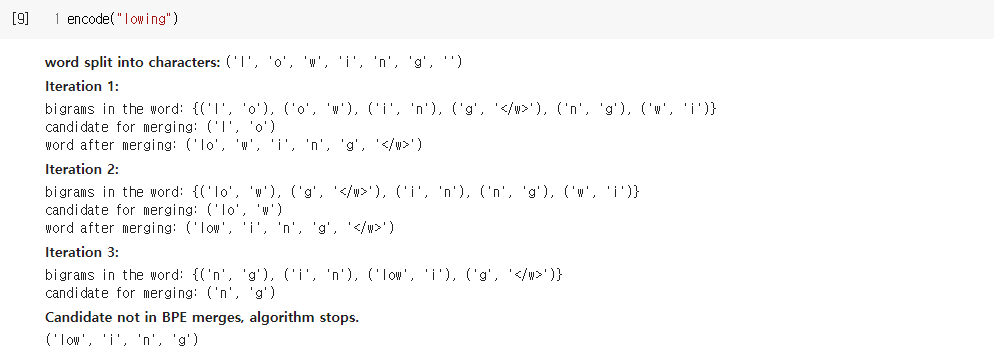

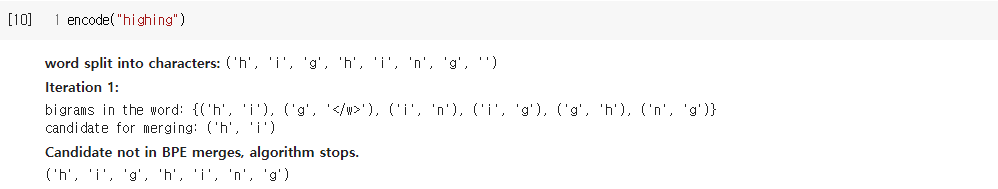

2. 자연어 처리에서의 BPE(Byte Pair Encoding)

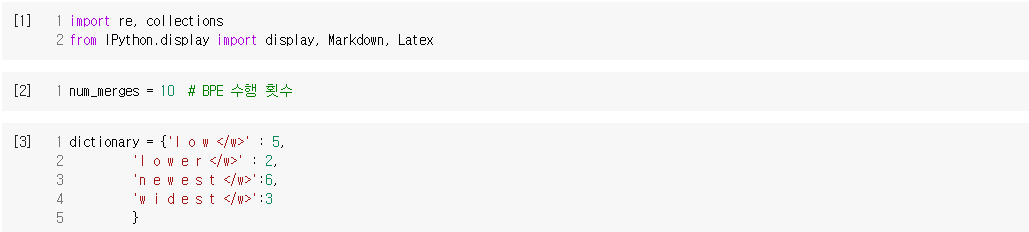

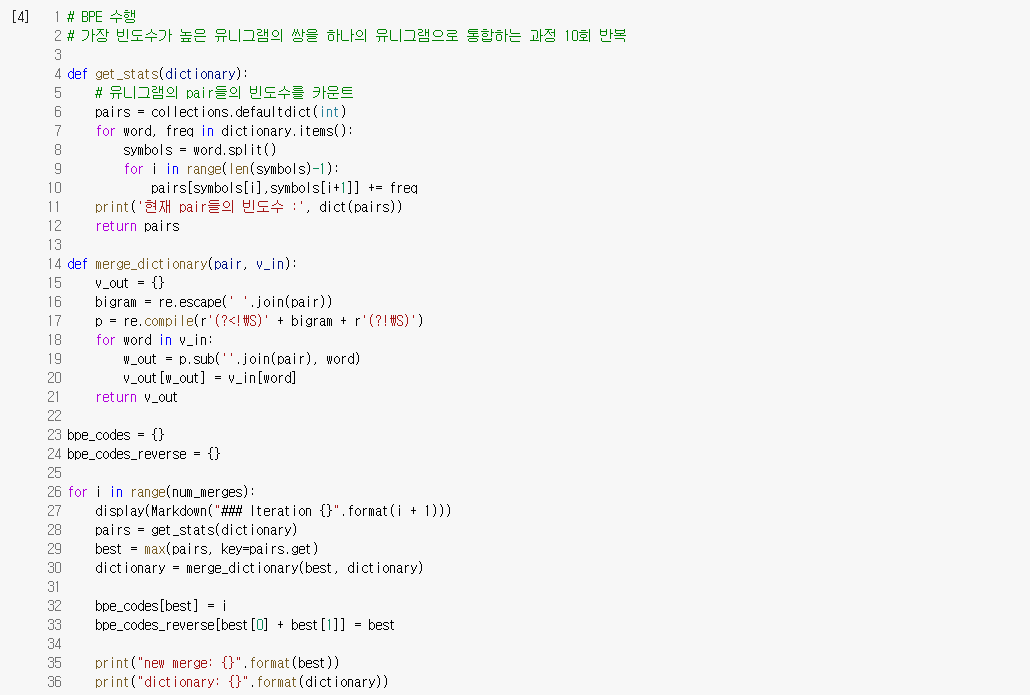

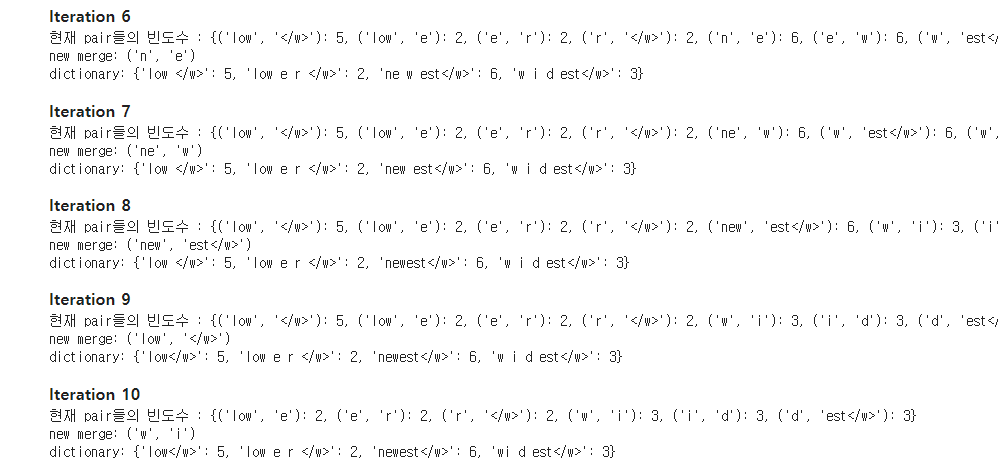

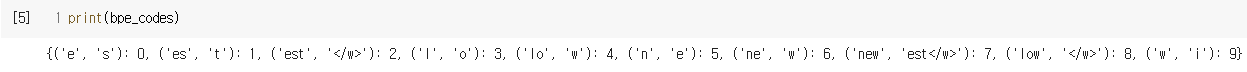

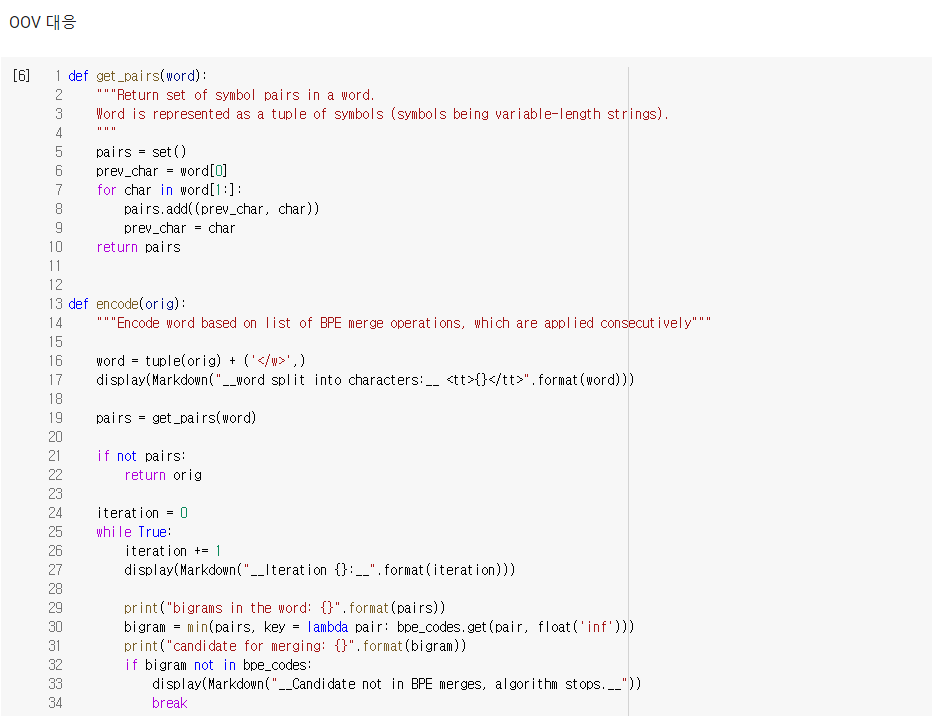

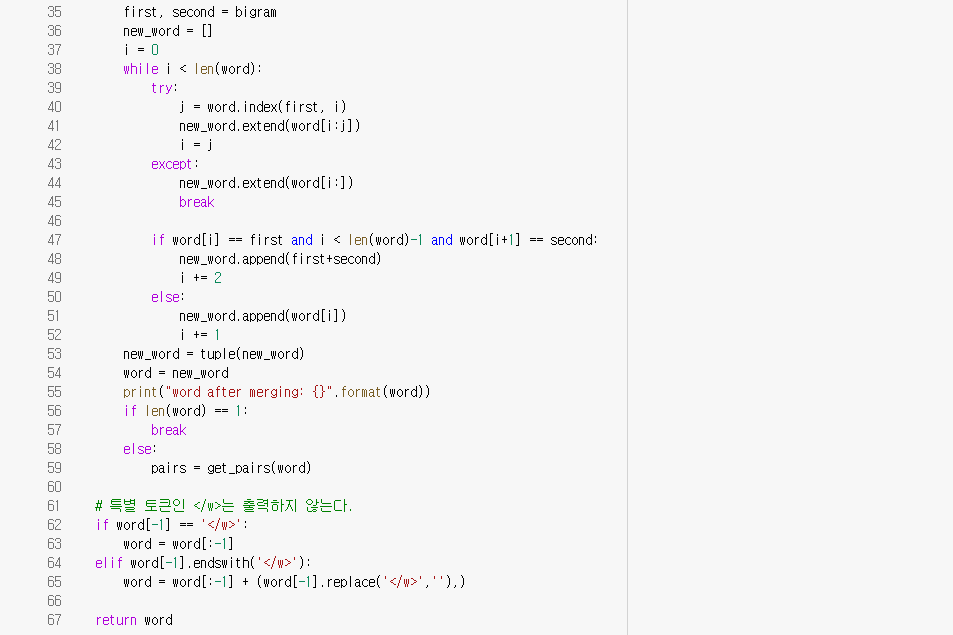

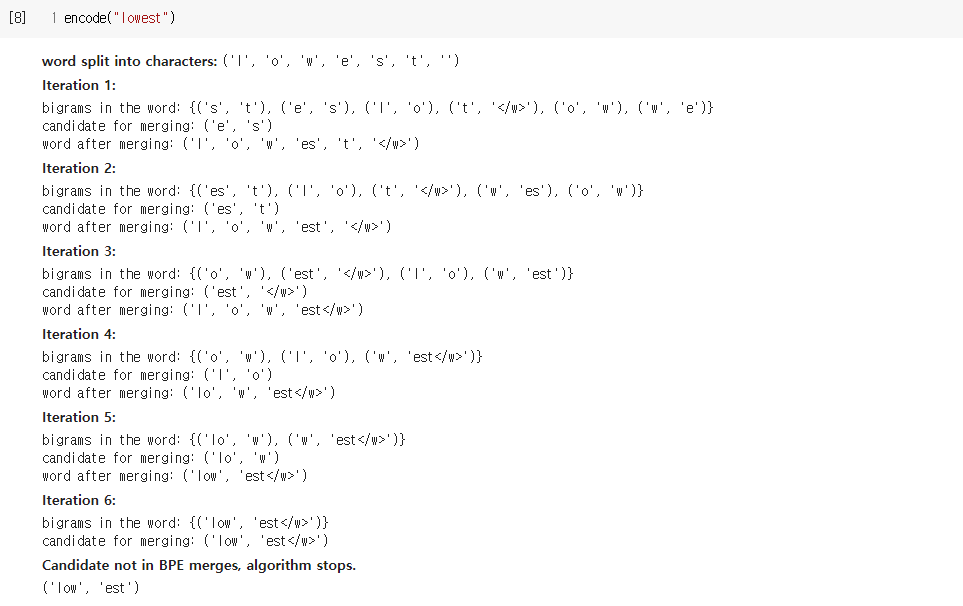

3. 코드 실습하기

.ipynb

0.01MB

- 출처 : [딥러닝을이용한 자연어 처리 입문] 1401 바이트 페어 인코딩(Byte Pair Encoding, BPE)

댓글

댓글 쓰기